W środę Google przedstawiło PaLM2, która jest rodziną podstawowych modeli językowych porównywalnych z modelem GPT-4 firmy OpenAI. Podczas wydarzenia Google I/O w Mountain View w Kalifornii Google ujawniło, że używa już PaLM 2 do zasilania 25 produktów, w tym konwersacyjnego asystenta AI Bard.

Jako rodzina dużych modeli językowych (LLM), PaLM 2 został przeszkolony na ogromnej ilości danych i wykonuje przewidywanie następnego słowa, które po szybkim wprowadzeniu przez ludzi tworzy najbardziej prawdopodobny tekst. PaLM oznacza Pathways Language Model iarkadato technologia uczenia maszynowego stworzona w Google. PaLM 2 śledzi plik Oryginalny PaLMOgłoszone przez Google w kwietniu 2022 r.

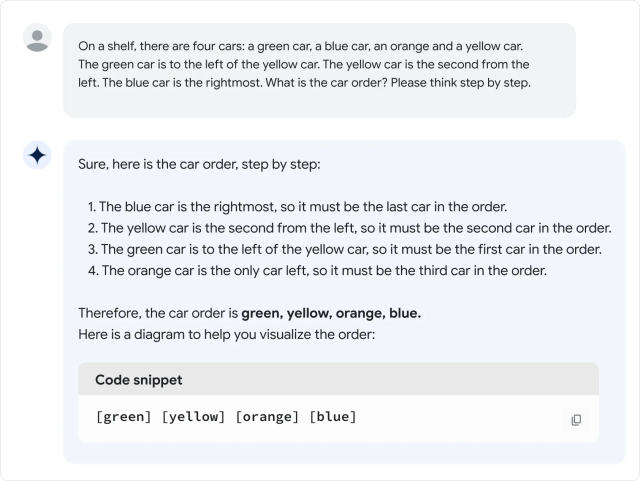

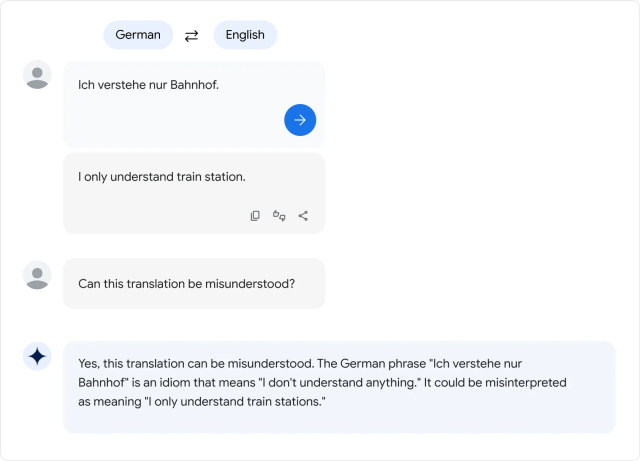

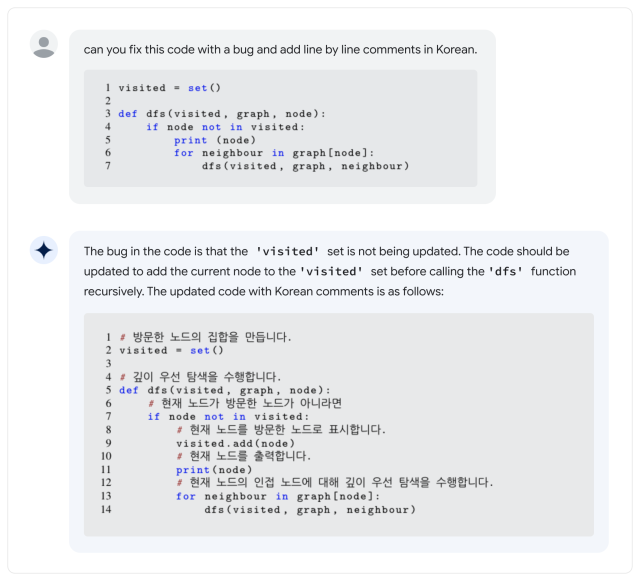

Według Google PaLM 2 obsługuje ponad 100 języków i może wykonywać „logiczne rozumowanie”, generować kod i tłumaczyć wielojęzycznie. Podczas swojego przemówienia na Google I/O 2023, dyrektor generalny Google Sundar Pichai powiedział, że PaLM 2 jest dostępny w czterech rozmiarach: Gecko, Otter, Bison i Unicorn. Gekon jest najmniejszy i można w niego grać na urządzeniu mobilnym. Oprócz Barda PaLM 2 stoi za funkcjami AI w dokumentach, arkuszach kalkulacyjnych i prezentacjach.

To wszystko dobrze i dobrze, ale jak PaLM 2 układa się w stos z GPT-4? w Raport techniczny PaLM 2PaLM2 Wydaje się Pokonać GPT-4 w niektórych zadaniach matematycznych, tłumaczeniowych i wnioskowania. Ale rzeczywistość może nie odpowiadać standardom Google. W szybkiej ocenie wersji PaLM 2 Barda przeprowadzonej przez Ethana Mollicka, profesora z Wharton, który często pisze o sztucznej inteligencji, Mollick stwierdził, że PaLM 2 wypada gorzej niż GPT-4 i Bing w kilku nieformalnych testach językowych, czyli Zawias w wątku na Twitterze.

Do niedawna rodzina modeli językowych PaLM była wewnętrznym produktem Google Research bez kontaktu z konsumentami, ale Google wystartował Zapewnij ograniczony dostęp do interfejsu API w marcu. Jednak pierwszy PaLM wyróżniał się ogromnymi rozmiarami: 540 miliardów parametrów. Parametry to zmienne numeryczne, które służą jako „wiedza” nabyta przez model, umożliwiając mu przewidywanie i generowanie skryptu na podstawie otrzymanych danych wejściowych.

Więcej parametrów oznacza z grubsza większą złożoność, ale nie ma gwarancji, że będą one efektywnie wykorzystywane. Dla porównania, GPT-3 OpenAI (stan na 2020 r.) Ma 175 miliardów parametrów. OpenAI nigdy nie ujawnił liczby parametrów w GPT-4.

A to prowadzi do wielkiego pytania: jak „duży” jest PaLM 2 pod względem liczby parametrów? Google nie mówco niektórych frustrowało Eksperci branżowi którzy często prowadzą kampanię na rzecz większej przejrzystości tego, co napędza modele AI.

To nie jedyna funkcja PaLM 2, której Google nie przeoczył. firma On mówi mówi, że PaLM 2 został przeszkolony na „różnych źródłach: dokumentach internetowych, książkach, kodzie, matematyce i danych konwersacyjnych”, ale nie podaje szczegółów, czym dokładnie są te dane.

Podobnie jak w przypadku innych dużych zestawów danych modeli językowych, zestaw danych PaLM 2 prawdopodobnie będzie zawierał szeroką gamę Materiał objęty prawami autorskimi Używane bez pozwolenia i materiałów, które mogą być szkodliwe Zdrapać Internet. Dane szkoleniowe mają krytyczny wpływ na dane wyjściowe dowolnego modelu AI, dlatego niektórzy eksperci opowiadają się za ich użyciem otwarte zbiory danych Może zapewnić możliwości reprodukcji naukowej i kontroli etycznej.

„Teraz, gdy LLM to produkty (a nie tylko badania), znajdujemy się w punkcie zwrotnym: firmy nastawione na zysk staną się *szczególnie* mniej przejrzyste co do tego, które komponenty mają największe znaczenie” ćwierkanie Jesse Dodge, naukowiec w Allena Instytut Sztucznej Inteligencji. „Tylko wtedy, gdy społeczność open source może się razem organizować, możemy nadążyć!”

Jak dotąd krytyka ukrywania tajnego sosu nie powstrzymała Google przed dążeniem do szerokiego wdrażania modeli AI, pomimo tendencji we wszystkich LLM do wymyślania rzeczy z powietrza. Podczas konferencji Google I/O przedstawiciele firmy zademonstrowali funkcje sztucznej inteligencji w kilku swoich flagowych produktach, co oznacza, że szeroki przekrój społeczeństwa może wkrótce walczyć z problemami sztucznej inteligencji.

A jeśli chodzi o LLM, PaLM 2 jest daleki od końca historii: podczas przemówienia I / O Pichai wspomniał, że nowy multimedialny model AI o nazwie „Gemini” jest obecnie w trakcie szkolenia. Ponieważ wyścig o dominację AI trwa, użytkownicy Google w Stanach Zjednoczonych i 180 innych krajów (nieznajomy z wyjątkiem Kanada i Europa kontynentalna) może Wypróbuj PaLM 2 sami W ramach Google Bard, eksperymentalnego asystenta AI.

. „Nieuleczalny entuzjasta muzyki. Bacon geek. Badacz internetu. Hipsterski miłośnik telewizji”.