Niektóre tygodnie w wiadomościach AI są niesamowicie ciche, ale podczas innych kontrolowanie wydarzeń tygodnia przypomina próbę powstrzymania fali. W tym tygodniu ukazały się trzy godne uwagi wydania Large Language Model (LLM): Google Gemini Pro 1.5 Ogólna dostępność W przypadku bezpłatnej warstwy OpenAI pobiera opłaty: nowy egzemplarz GPT-4 Turbo i Mistral wypuściły nowy LLM na otwartej licencji, Mieszany 8x22B. Od wtorku trzy starty miały miejsce w ciągu 24 godzin.

Z pomocą inżyniera oprogramowania i niezależnego badacza sztucznej inteligencji Simona Willisona (który także… Książki o (Frantic LLM wystartuje w tym tygodniu na swoim własnym blogu), omówimy pokrótce każde z trzech głównych wydarzeń w mniej więcej porządku chronologicznym, a następnie zagłębimy się w kilka dodatkowych wydarzeń AI w tym tygodniu.

Wersja ogólna Gemini Pro 1.5

We wtorek rano czasu pacyficznego, Google Ogłaszać Model Gemini 1.5 Pro (o którym po raz pierwszy pisaliśmy w lutym) jest teraz dostępny w ponad 180 krajach, z wyjątkiem Europy, za pośrednictwem interfejsu API Gemini w publicznej wersji zapoznawczej. Jest to najpotężniejszy ogólny certyfikat LLM oferowany dotychczas przez firmę Google i jest dostępny w warstwie bezpłatnej, która pozwala na maksymalnie 50 aplikacji dziennie.

Obsługuje do 1 miliona tokenów kontekstu wejściowego. Jak zauważa Willison Na swoim blogucena API dla Gemini 1.5 Pro wynosi 7 USD/mln kodów wejściowych, a 21 USD/mln kodów wyjściowych kosztuje nieco mniej niż GPT-4 Turbo (rozsądne ceny 10 dolarów za milion przy wejściu i 30 dolarów za milion dolarów) i więcej Claude 3 Sonnet (MBA średniego szczebla w Anthropic, rozsądne ceny Przy kwocie 3/milion dolarów przychodzących i 15 dolarów/milion wychodzących).

Warto dodać, że Gemini 1.5 Pro zawiera natywne przetwarzanie danych wejściowych głosowych (mowy), które umożliwia użytkownikom przesyłanie podpowiedzi audio lub wideo, nowe API plików do obsługi plików, możliwość dodawania niestandardowych instrukcji systemowych (podpowiedzi systemowych) w celu kierowania odpowiedzi z formularzy, oraz tryb JSON. Ekstrakcja danych strukturalnych.

Wprowadzenie na rynek „znacznie ulepszonego” GPT-4 Turbo.

Krótko po tym, jak Google wypuściło we wtorek wersję 1.5 Pro, OpenAI ogłosiło, że wypuszcza „znacznie ulepszoną” wersję GPT-4 Turbo (rodzina modeli pierwotnie wprowadzona na rynek w listopadzie) o nazwie „gpt-4-turbo-2024-04”-09. „Integruje wielomodalne przetwarzanie wizyjne GPT-4 (rozpoznawanie treści obrazu) bezpośrednio z modelem i początkowo jest uruchamiane wyłącznie poprzez dostęp API.

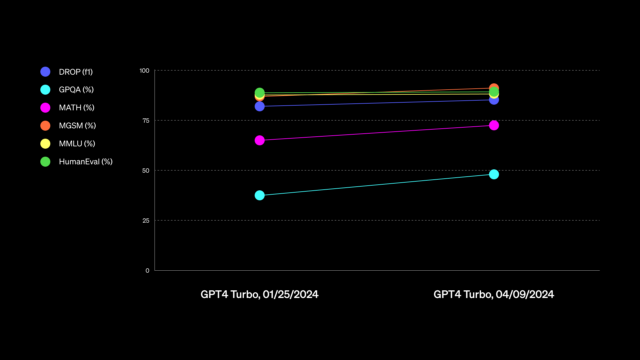

Następnie w czwartek OpenAI ogłosiło, że nowy model GPT-4 Turbo stanie się dostępny dla płatnych użytkowników ChatGPT. OpenAI stwierdziło, że nowy model poprawia „umiejętności pisania, matematyki, logicznego myślenia i kodowania”. Wykres udostępniony Nie jest to szczególnie przydatne w ocenie umiejętności (co później zrobili Zaktualizowano). Firma też Podałem przykład o rzekomym ulepszeniu, mówiąc, że podczas pisania za pomocą ChatGPT asystent AI będzie „bardziej bezpośredni, mniej gadatliwy i będzie używał bardziej konwersacyjnego języka”.

Niejasny charakter ogłoszeń OpenAI GPT-4 Turbo przyciągnął niektórych dezorientacja I krytyka w internecie. 10-tego Willisona książki„Kto będzie pierwszym dostawcą LLM, który opublikuje naprawdę przydatne informacje o wersji?” W pewnym sensie jest to ponownie przypadek „nastroju wobec sztucznej inteligencji”, o czym pisaliśmy w naszym lamentowaniu nad złym stanem standardów LLM podczas debiutu Cloud 3. „Właściwie nie stwierdziłem żadnych konkretnych różnic w jakości [related to GPT-4 Turbo]„, Willison powiedział nam bezpośrednio w wywiadzie.

Aktualizacja rozszerzyła także limit wiedzy GPT-4 do kwietnia 2024 r., chociaż niektóre osoby zgłaszały, że osiąga to poprzez… Ukryte wyszukiwania w Internecie W tle inni są w mediach społecznościowych Zgłoszone problemy Z niejasnościami związanymi z historią.

Mistral Mystery Edition Mixtral 8x22B

Aby nie dać się wyprzedzić, francuska firma Mistral zajmująca się sztuczną inteligencją we wtorek wieczorem wprowadziła na rynek swój najnowszy model na otwartej licencji, Mixtral 8x22B, za pośrednictwem… Tweetnij z linkiem do torrenta Podobnie jak w przypadku poprzednich wersji, pozbawiona jest jakiejkolwiek dokumentacji i komentarzy.

Nowa hybrydowa edycja Experts (MoE) oferuje większą liczbę parametrów niż poprzednio bardziej wydajny model otwarty, Mieszany 8x7B, o którym pisaliśmy w grudniu. Krążą pogłoski, że ma potencjalnie takie same możliwości jak GPT-4 (w jaki sposób? Wibracje). Ale tego jeszcze nie widziano.

„Oceny wciąż trwają, ale największą otwartą kwestią jest teraz to, jak dobrze ukształtowany jest Mixtral 22x8B” – Willison powiedział Ars. „Jeśli będzie w tej samej klasie jakości co GPT-4 i Claude 3 Opus, w końcu będziemy mieli model na otwartej licencji, który nie odbiega znacząco od najlepszych modeli zastrzeżonych”.

To wydanie bardzo podekscytowało Willisona, mówiąc: „Jeśli to naprawdę jest GPT-4, to jest szalone, ponieważ można go uruchomić na (drogim) laptopie. Myślę, że do tego potrzebny jest MacBook 128 GB RAM, czyli „dwa razy więcej Potrzebowałem.” Jest właścicielem.

Willison zauważył, że nowe oprogramowanie Mixtral nie zostało jeszcze uwzględnione w Chatbot Arena, ponieważ Mistral nie wypuścił jeszcze dokładnego modelu czatu. Jest to nadal prototypowy program do przewidywania kolejnego tokena LLM. „Obecnie istnieje co najmniej jedna kontrolowana wersja instrukcji społecznych” – mówi Willison.

Zmiany w tabeli liderów w Chatbot Arena

Binga Edwardsa

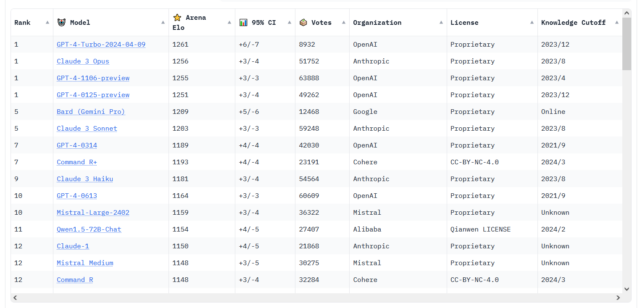

W tym tygodniu wiadomości LLM nie dotyczą tylko wielkich nazwisk w tej dziedzinie. W mediach społecznościowych pojawiły się również pogłoski na temat zwiększonej wydajności modeli open source, takich jak model Cohere Komenda R+każdy Osiągnięto pozycję 6 W tabeli liderów LMSYS Chatbot Arena – najwyższy ranking w historii modelu Open Weights.

A jeśli chodzi o więcej emocji w Chatbot Arena, wydaje się, że nowa wersja GPT-4 Turbo okazała się konkurencyjna w stosunku do Claude 3 Opus. Obie drużyny nadal mają statystyczny remis, ale ostatnio GPT-4 Turbo Pociągnąłem do przodu liczebnie. (W marcu informowaliśmy, że Claude 3 po raz pierwszy przewodził cyfrowo w GPT-4 Turbo, co było pierwszym przypadkiem, w którym inny model AI pokonał w tabeli liderów model z rodziny GPT-4).

Odnosząc się do tej ostrej konkurencji między LLM – o której większość świata przemytniczego nie jest świadoma i prawdopodobnie nigdy nie będzie świadoma – Wilson powiedział Ars: „Ostatnie kilka miesięcy było burzliwe – w końcu mamy nie tylko jeden, ale kilka modeli zdolnych konkurować z GPT-4. Zobaczymy, czy plotki o premierze GPT-5 przez OpenAI jeszcze w tym roku przywrócą firmie wiodącą pozycję technologiczną, która kiedyś wydawała się nie do pokonania. Ale na razie Willison mówi: „OpenAI nie jest już niekwestionowanym liderem w dziedzinie studiów MBA”.

. „Nieuleczalny entuzjasta muzyki. Bacon geek. Badacz internetu. Hipsterski miłośnik telewizji”.